Zadowolony

Praca optymalizatora SEO jest bardzo rozbudowana. Początkującym ekspertom zaleca się napisanie algorytmu optymalizacji, tak aby nie pominąć żadnego etapu. W przeciwnym razie promocję trudno będzie nazwać udaną, gdyż na stronie będą stale występowały awarie i błędy, których naprawa zajmie dużo czasu.

Jednym z etapów optymalizacji jest praca z plikiem robotów.txt. Ten dokument powinien być przy każdym zasobie, bo bez niego trudniej będzie poradzić sobie z optymalizacją. Pełni wiele funkcji, które będziesz musiał zrozumieć.

Asystent robota

Akta robotów.txt jest zwykłym dokumentem tekstowym, który może być przeglądany w standardowym Notatniku. Podczas tworzenia go należy ustawić kodowanie UTF-8, aby został on poprawnie odczytany. Plik współpracuje z protokołami http, https i FTP.

Ten dokument jest pomocnikiem dla wyszukiwarek. Jeśli nie wiesz, każdy system używa "pająków", które szybko skanują World Wide Web, aby stworzyć odpowiednie strony dla żądań użytkownika. Roboty te muszą mieć dostęp do danych o zasobach, a roboty do tego.txt.

Aby pająki znalazły ścieżkę, należy złożyć dokument z robotami.txt do katalogu głównego. Aby sprawdzić, czy strona posiada ten plik, wpisz "https://site.com.ua/roboty.txt". Zamiast "strony.com.ua" należy wprowadzić niezbędny zasób.

Funkcje dokumentów

Roboty.txt dostarcza wyszukiwarkom kilka rodzajów informacji. Może dać częściowy dostęp pająkowi do konkretnych elementów zasobu. Pełny dostęp umożliwia crawlerom przeszukiwanie wszystkich dostępnych stron. Całkowity zakaz uniemożliwia robotom nawet rozpoczęcie sprawdzania, a one same opuszczają stronę.

Po odwiedzeniu zasobu, pająki otrzymują odpowiednią odpowiedź. Może być ich kilka, w zależności od informacji zawartych w robotach.txt. Na przykład, jeśli skanowanie zakończy się sukcesem, robot otrzyma kod 2xx.

Strona mogła zostać ustawiona na przekierowanie z jednej strony na drugą. W tym przypadku kod 3xx jest pobierany przez robota. Jeśli ten kod wystąpi wiele razy, pająk będzie go śledził, dopóki nie otrzyma innej odpowiedzi. Chociaż zazwyczaj wykorzystuje tylko 5 prób. W przeciwnym razie pojawia się popularny komunikat o błędzie 404.

Jeśli odpowiedź brzmi 4xx, oznacza to, że robot może skanować wszystkie treści na stronie. Ale w przypadku 5xx, może to całkowicie zatrzymać indeksowanie, ponieważ często wskazuje na tymczasowe błędy serwera.

Do czego służą roboty?.txt?

Jak można się domyślić, ten plik prowadzi roboty do korzenia strony. Obecnie jest on wykorzystywany do częściowego ograniczania dostępu do niepożądanych treści:

- strony z osobistymi informacjami o użytkowniku;

- strony lustrzane;

- wyniki wyszukiwarek;

- formularze do przekazywania danych itp.

Jeśli nie ma pliku robots w korzeniu strony.txt, to robot przeskanuje absolutnie wszystkie treści. W związku z tym w danych wyjściowych mogą pojawić się niechciane dane, przez co zarówno użytkownik, jak i strona mogą ucierpieć. Jeśli roboty.txt są specjalne instrukcje, więc "pająk" będzie je wykonywał i produkował informacje pożądane przez właściciela zasobu.

Praca z plikiem

Aby użyć robotów.txt, aby zamknąć stronę przed indeksacją, konieczne jest zrozumienie, jak stworzyć ten plik. Aby to zrobić, postępuj zgodnie z instrukcjami:

- Utwórz dokument w programie Notatnik lub Notepad++.

- Ustaw rozszerzenie pliku ".txt".

- Wprowadzić niezbędne dane i polecenia.

- Zapisz dokument i prześlij go do głównego katalogu witryny.

Jak widać, na jednym z etapów ustalania poleceń dla robotów. Występują one w dwóch rodzajach: allow (Zezwalaj) i deny (Zaprzeczaj). Ponadto, niektóre optymalizatory mogą określić prędkość obchodzenia, host i link do mapy strony zasobów.

Aby rozpocząć pracę z robotami.txt i całkowicie zamknąć stronę przed indeksowaniem, musisz również zrozumieć symbole używane. Na przykład w dokumencie można użyć "/", co oznacza, że cała strona jest indeksowana. Jeśli użyto "*", oznacza to, że wymagany jest ciąg znaków. Pozwoli to na określenie konkretnego folderu, który może być badany lub nie.

Osobliwość botów

"Pająki" przez wyszukiwarki są różne, więc jeśli pracujesz z kilkoma wyszukiwarkami jednocześnie, będziesz musiał wziąć to pod uwagę. Mają one różne nazwy, więc jeśli chcesz zwrócić się do konkretnego robota, musisz podać jego nazwę: "User Agent: Yandex" (bez cudzysłowu).

Jeśli chcesz określić dyrektywy dla wszystkich wyszukiwarek, musisz użyć polecenia "User Agent": *" (bez cudzysłowu). W celu prawidłowego wykorzystania robotów.txt, aby zamknąć stronę przed indeksacją, należy poznać specyfikę popularnych wyszukiwarek.

Fakt, że najpopularniejsze wyszukiwarki Yandex i Google mają kilka botów. Każdy z nich ma swoje zadania do wykonania. Na przykład Yandex Bot i Googlebot są głównymi "pająkami", które indeksują stronę. Znając wszystkie boty łatwiej będzie dopracować pracę nad indeksowaniem Twojego zasobu.

Przykłady

Więc, z robotami.txt, aby zamknąć stronę przed indeksowaniem mogą być proste polecenia, najważniejsze jest zrozumienie, co jest potrzebne w szczególności. Na przykład, jeśli chcesz, aby robot Google nie zbliżał się do Twojego zasobu, musisz wydać mu odpowiednie polecenie. Będzie to wyglądało tak: "User-agent: Googlebot Disallow: /" (bez cudzysłowów).

Teraz musimy rozbić, co jest w tym poleceniu i jak ono działa. Do bezpośredniego odwołania się do niektórych botów używa się więc "User-agent". Następnie określamy, który to jest, w naszym przypadku jest to Google. Polecenie "Disallow" powinno zaczynać się od nowej linii i zabraniać robotowi wejścia na stronę. Ukośnik w tym przypadku oznacza, że wszystkie strony zasobu są wybrane do wykonania.

W robotach.txt zakaz indeksowania dla wszystkich wyszukiwarek można zrobić za pomocą prostego polecenia: "User-agent: * Disallow: /" (bez cudzysłowów). Symbol gwiazdki w tym przypadku oznacza wszystkie wyszukiwarki. To polecenie jest zwykle potrzebne, aby zawiesić indeksowanie strony i rozpocząć radykalne prace na stronie, które mogłyby w inny sposób wpłynąć na optymalizację.

Jeśli zasób jest duży i ma wiele stron, często znajdują się w nim informacje zastrzeżone, które są niepożądane lub mogą negatywnie wpłynąć na promocję. W tym przypadku należy rozumieć, że, jak zamknąć strona nie zostanie zaindeksowana przez roboty.txt.

Możliwe jest ukrycie zarówno folderu jak i pliku. W pierwszym przypadku, ponownie, musisz zacząć od adresowania konkretnego bota lub wszystkich, więc użyj polecenia "User-agent", a poniżej określ polecenie "Disallow" dla konkretnego folderu. Będzie to wyglądało tak: "Disallow: /folder/" (bez cudzysłowów). Spowoduje to ukrycie całego folderu. Jeśli istnieje jakiś ważny plik, który chcielibyśmy pokazać, należy napisać poniższe polecenie: "Allow: /folder/plik.php" (bez cudzysłowu).

Sprawdzenie pliku

W przypadku stosowania robotów.txt, aby zamknąć stronę przed indeksowaniem udało Ci się, ale nie wiesz czy wszystkie Twoje dyrektywy zadziałały poprawnie, możesz sprawdzić.

Najpierw należy ponownie sprawdzić lokalizację dokumentu. Pamiętaj, że musi on znajdować się tylko w folderze głównym. Jeśli trafi do podfolderu, nie będzie działać. Następnie należy otworzyć przeglądarkę i wpisać adres: "http://вашсайт. com/roboty.txt" (bez cudzysłowu). Jeśli Twoja przeglądarka dostanie błąd, plik jest w złym miejscu.

Dyrektywy można sprawdzić w specjalnych narzędziach, które są używane przez prawie wszystkich webmasterów. Mówimy o produktach Google i Yandex. Google Search Console, na przykład, ma pasek narzędzi, w którym otwierasz "Skanowanie", a następnie uruchamiasz narzędzie do skanowania plików "robots.txt.txt". Wszystkie dane z dokumentu muszą być skopiowane do okna i należy uruchomić skanowanie. Dokładnie to samo można sprawdzić w "Yandexie".Webmaster".

Jak przywrócić usuniętą stronę vkontakte: instrukcje i metody

Jak przywrócić usuniętą stronę vkontakte: instrukcje i metody Montaż wanny przed lub po ułożeniu płytek: metody, techniki, instrukcje

Montaż wanny przed lub po ułożeniu płytek: metody, techniki, instrukcje Abdominoplastyka brzucha: zdjęcia przed i po, opinie pacjentów, cechy procedury

Abdominoplastyka brzucha: zdjęcia przed i po, opinie pacjentów, cechy procedury Jak zachować się po raz pierwszy na lotnisku: instrukcje i przydatne wskazówki

Jak zachować się po raz pierwszy na lotnisku: instrukcje i przydatne wskazówki Co to jest peeling węglowy: opis zabiegu, cel, opinie, zdjęcia przed i po

Co to jest peeling węglowy: opis zabiegu, cel, opinie, zdjęcia przed i po Jak zacząć prowadzić stronę biznesową na facebooku: instrukcje krok po kroku, porady i wskazówki

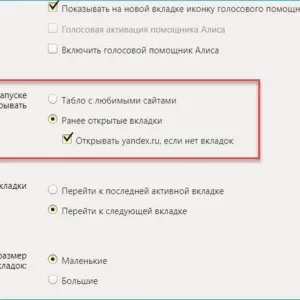

Jak zacząć prowadzić stronę biznesową na facebooku: instrukcje krok po kroku, porady i wskazówki Jak zmienić swoją stronę główną yandex.przeglądarka: instrukcje

Jak zmienić swoją stronę główną yandex.przeglądarka: instrukcje Dieta gryczana i kefirowa: recenzje i wyniki, opinie ekspertów, zdjęcia przed i po

Dieta gryczana i kefirowa: recenzje i wyniki, opinie ekspertów, zdjęcia przed i po Jak odzwyczaić dziecko od bujania przed snem: skuteczne metody, cechy i świadectwa

Jak odzwyczaić dziecko od bujania przed snem: skuteczne metody, cechy i świadectwa